DeepSpeed-Chat nowy system zwiększający dostępności trenowania LLM

Poniższy tekst jest tłumaczeniem mojego artykułu w języku angielskim.

DeepSpeed-Chat to nowy system wprowadzony przez badaczy z Microsoftu, który ma na celu przyspieszenie, obniżenie kosztów i zwiększenie dostępności trenowania dużych konwersacyjnych modeli AI takich jak ChatGPT. System łączy optymalizacje z DeepSpeed training i inference w jednolitą platformę zwaną Hybrid Engine, która zapewnia bezprecedensową wydajność dla treningu RLHF.

Najważniejsze informacje:

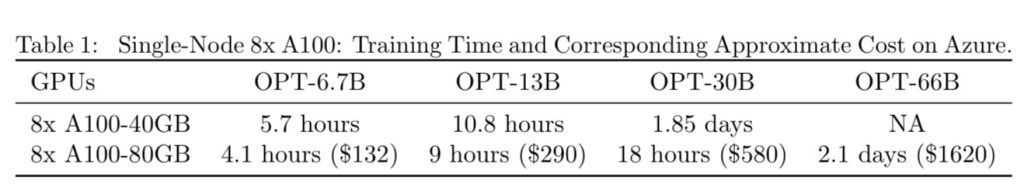

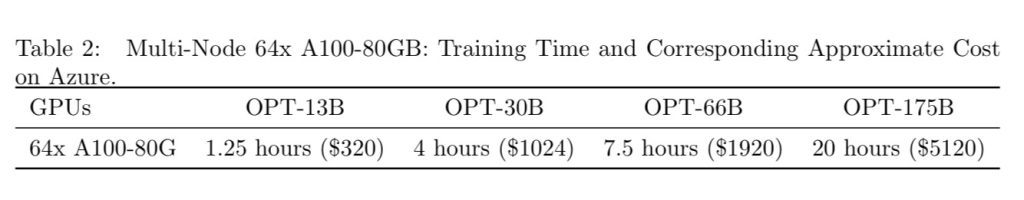

- Umożliwia trening modeli konwersacyjnych o parametrach 13B i 30B za mniej niż 300 i 600 dolarów odpowiednio na platformie Azure cloud przy całkowitym czasie treningu wynoszącym 9 i 18 godzin. Jest to ponad 15x szybsze od istniejących systemów.

- Wspiera trening modeli o setkach miliardów parametrów. Model o 175B parametrów może być wytrenowany w mniej niż 1 dzień na małym klastrze.

- Udostępnia RLHF nawet na pojedynczym GPU, gdzie możliwy jest trening modelu 13B.

System zapewnia prosty interfejs użytkownika pozwalający trening modeli w stylu ChatGPT z pojedynczego skryptu. Odwzorowuje pełen proces treningu InstructGPT składający się z 3 kluczowych etapów – nadzorowanego fine-tuningu (ang. supervised fine-tuning), fine-tuningu modelu nagród (ang. reward model fine-tuning) i RLHF (Reinforcement Learning From Human Feedback).

DeepSpeed-Chat oferuje znacznie wyższą wydajność, osiągając ponad 10x szybszy trening w porównaniu do istniejących systemów opartych na PyTorch. Zyski wynikają z możliwości Hybrid Engine do płynnej zmiany pomiędzy zoptymalizowanym trybem inferencji i treningu.

System ten stanowi znaczący krok w kierunku demokratyzacji dostępu do dużych konwersacyjnych modeli AI. Badacze i startupy z ograniczonymi zasobami mogą teraz trenować wysokiej jakości modele bez konieczności posiadania drogiej infrastruktury. Udostępnienie kodu źródłowego umożliwia również szerszą innowację w dynamicznie rozwijającej się dziedzinie.

Możliwe implikacje:

- Szersze zastosowanie konwersacyjnego AI w aplikacjach konsumenckich, usługach dla firm, etc. dzięki łatwemu dostępowi do wysokiej jakości modeli

- Zintensyfikowanie badań nad technikami takimi jak instruction tuning czy prompt programming w celu poprawy odporności i możliwości modeli LLMs

- Umożliwienie małym firmom i startupom konkurowania w obszarze konwersacyjnego AI z technologicznymi gigantami

Podsumowując, zdolność DeepSpeed-Chat do efektywnego treningu modeli w skali ChatGPT otwiera ekscytujące możliwości zarówno badań jak i praktycznych zastosowań konwersacyjnego AI. Demokratyzacja dostępu może znacząco przyspieszyć postęp w tej przełomowej technologii.

Zobacz też: DeepSpeedExamples on GitHub