Jak oceniać AI mądrzejsze od ludzi?

Badacze wymyślili sprytny sposób na testowanie zaawansowanych modeli AI, nawet gdy są one mądrzejsze od ludzi w danej dziedzinie.

Ich pomysł polega na sprawdzeniu, czy odpowiedzi AI są logicznie spójne. Na przykład:

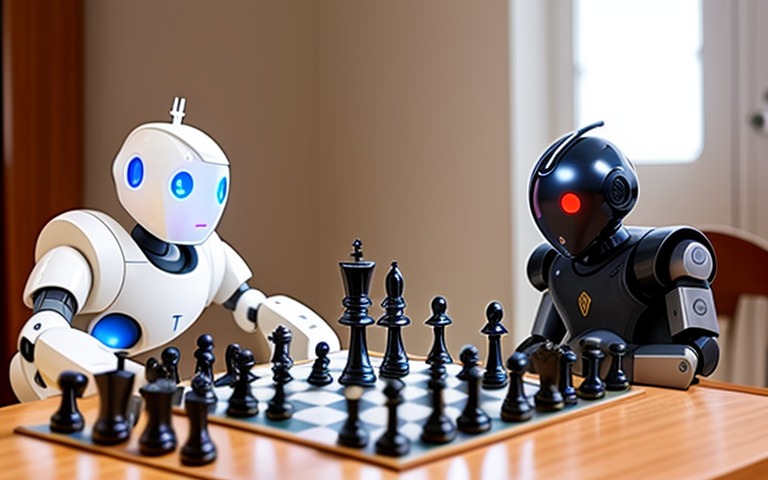

- Jeśli szachowa AI stwierdza, że pozycja jest wygrana, nie powinna później twierdzić, że identyczna pozycja jest przegrana. To jest ewidentnie niespójne!

- Jeśli AI prognozująca pogodę mówi, że dzisiaj jest 20% szans na deszcz, powinna twierdzić, że jest 80% szans, że deszczu nie będzie. Prawdopodobieństwa powinny się sumować do 100%.

- Jeśli AI prawnicza nie rekomenduje zwolnienia za kaucją dla przestępcy z 1 wyrokiem, nie powinna rekomendować zwolnienia za kaucją dla tego samego przestępcy z 2 wyrokami. Więcej przestępstw powinno oznaczać mniejszą szansę na zwolnienie za kaucją.

Więc nawet jeśli ludzie nie potrafią już stwierdzić, czy pojedyncze odpowiedzi AI są poprawne, wciąż możemy zauważyć, gdy grupa odpowiedzi nie ma sensu logicznie.

Badacze przetestowali ten pomysł na szachowych AI, językowych AI próbujących przewidzieć przyszłość i prawniczych AI decydujących o zwolnieniu za kaucją. Wszystkie popełniały oczywiste błędy logiczne, ujawniając luki w ich rozumowaniu.

To ekscytujące, ponieważ do tej pory wydawało się niemożliwe, by ocenić AI, które przewyższają inteligencją ludzi. Ta technika daje nam jednak sposób na zauważanie problemów w super-inteligentnych systemach.

Kolejne wyzwania to opracowanie jeszcze trudniejszych testów logicznych dla AI oraz automatyzacja generowania testów. Ale to ważny pierwszy krok w zapewnieniu, że przyszłe systemy AI, które budujemy, będą logiczne i godne zaufania!

Jeśli temat Cię zainteresował polecam też mój, nieco obszerniejszy, artykuł na ten temat w języku angielskim.